Suite du billet précédent : L’univers holographique (5) : la quête des dualités ET FIN

La correspondance AdS/CFT, et plus généralement les dualités holographiques, ont soulevé énormément d’enthousiasme dans la communauté des cordistes, suscité des milliers de publications et des centaines de thèses de doctorat – ce qui après tout constitue l’activité courante et « normale » de la recherche scientifique. On peut cependant rester perplexe devant un tel phénomène qui, au-delà de l’intérêt technique certain qu’il peut représenter, relève surtout d’une certaine dérive sociologique pointée du doigt par d’éminents chercheurs de la discipline[1].

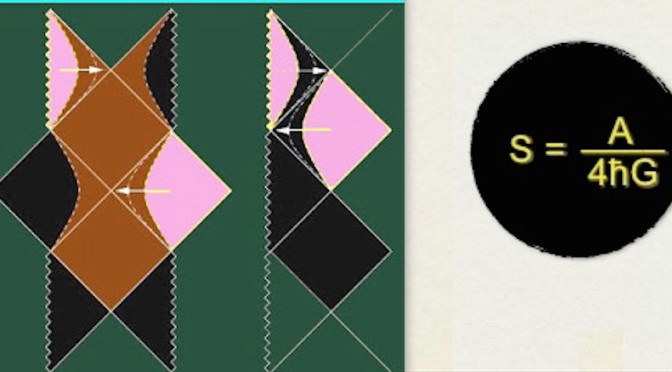

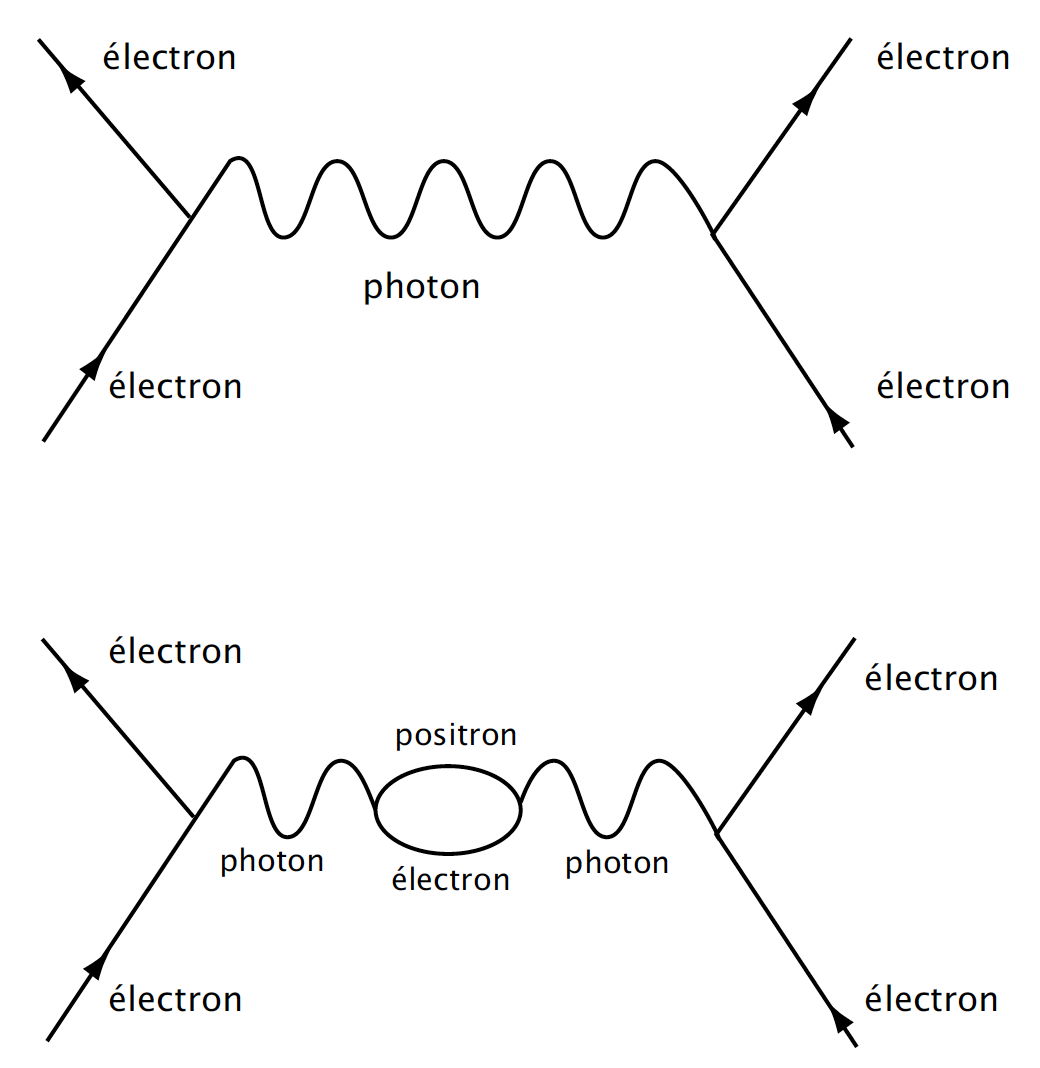

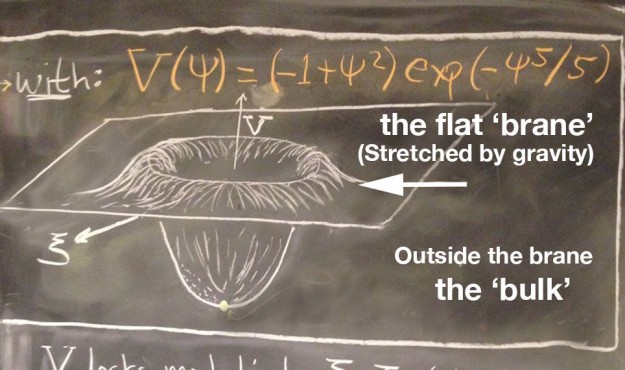

Au crédit de la correspondance, il faut reconnaître qu’elle permet de troquer certains calculs difficiles, voire impossibles, contre des calculs plus faciles. A minima, la dualité holographique apparaît comme un intéressant outil de calcul en physique fondamentale. Le “dictionnaire” qu’elle propose entre le monde en espace-temps plat et le monde courbe où se trouve la gravitation fonctionne dans les deux sens. Certains calculs sont plus simples avec la supergravité que dans la théorie de jauge duale, de sorte qu’aucun de ces mondes n’est plus fondamental que l’autre. Mais ce n’est pas parce que l’on peut considérer des calculs plus simplement dans un espace-temps plat, sans gravitation et de plus basse dimension que celui de la théorie des cordes, qu’il en découle que la réalité cosmique est un hologramme ! On peut entièrement encoder la topographie 3D d’un terrain dans une carte 2D sur laquelle le relief est indiqué par des courbes de niveau (un encodage bien utile aux randonneurs), mais, selon le célèbre aphorisme d’Alfred Korzybski, il ne faut jamais perdre de vue que « la carte n’est pas le territoire »[2].

A son crédit également, et là je parle en ardent pratiquant de la théorie de la relativité générale classique dont nous célébrons cette année le centenaire[3], la dualité jauge/gravité a conféré à la théorie d’Einstein un statut beaucoup plus large. L’édifice intellectuel de la relativité générale a certes connu de remarquables succès au cours du siècle dernier, et fourni un édifice crucial pour toute la partie de la physique théorique traitant de la gravitation. La révolution conceptuelle qu’elle a entraînée sur la nature de l’espace et du temps a rendu la théorie populaire, au point qu’il serait difficile de trouver aujourd’hui une personne possédant un minimum de culture scientifique mais n’ayant jamais entendu parler de la théorie d’Einstein.

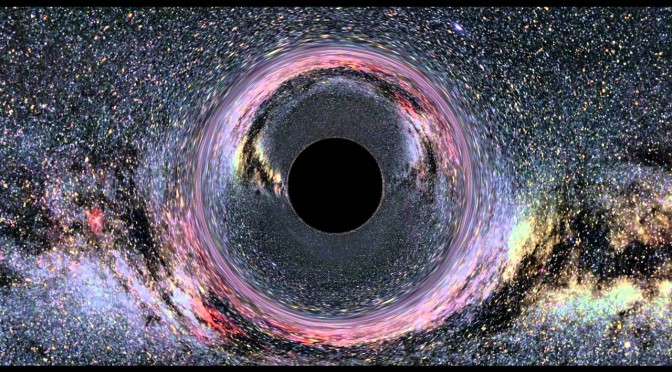

Continuer la lecture de L’univers holographique (6) : Black Holism