Suite du billet précédent L’univers holographique (2) : la gravité quantique façon théorie des cordes

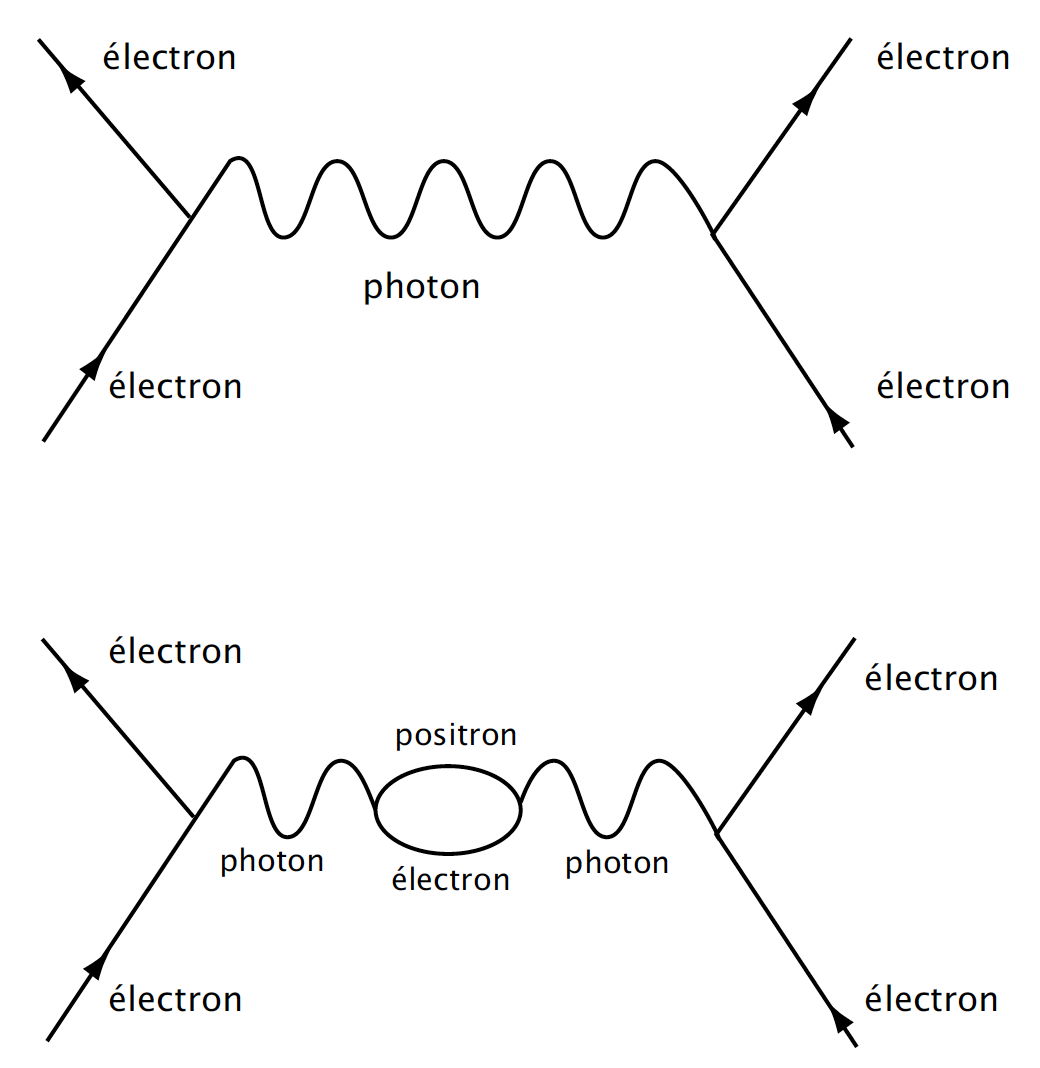

Dans le cadre de la théorie des cordes, il s’agissait dans un premier temps de retrouver les lois de la thermodynamique classique des trous noirs, c’est-à-dire savoir calculer, en termes de mécanique statistique quantique, leur entropie et leur température en fonction de leur aire et de leur gravité de surface. La tâche n’est pas aisée. Comme en thermodynamique, l’entropie mesure le nombre total d’états microscopiques internes correspondant à un état externe donné du trou noir, défini par ses trois paramètres (M, J, Q). Encore faut-il comptabiliser les « vrais » états microscopiques, c’est-à-dire les degrés de liberté ultimes sur lesquels il faut calculer l’entropie. Pour évaluer le contenu ultime en informations d’un élément de matière, c’est-à-dire son entropie thermodynamique, il faut en toute rigueur connaître ses constituants fondamentaux au niveau le plus profond de structuration. Dans le modèle standard de la physique des particules, les quarks et les leptons semblent suffisants pour coder toute l’information. Mais dans la théorie des cordes et sa théorie-mère (M-theory), les quarks et les leptons sont des états excités de supercordes, qui deviennent alors les constituants les plus élémentaires du monde physique.

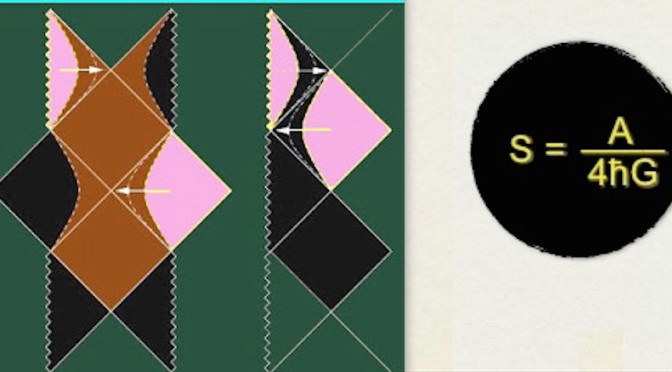

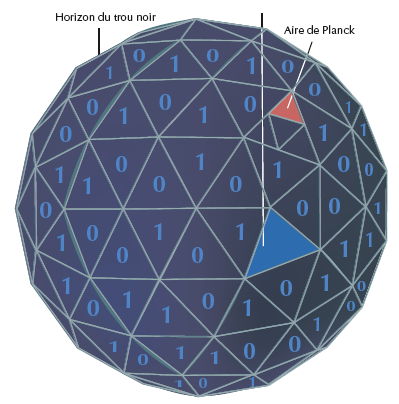

En 1993, Gerard t’Hooft (futur lauréat du prix de Nobel de physique 1999 pour ses travaux sur l’interaction électrofaible) fut le premier à revisiter le travail de Hawking sur la thermodynamique des trous noirs dans le cadre de la théorie des cordes. Il calcula que le nombre total de degrés de liberté dans le volume d’espace-temps intérieur au trou noir était proportionnel à la superficie de son horizon[1]. La surface bidimensionnelle du trou noir peut être divisée en unités quantiques fondamentales appelées aires de Planck (10–66 cm2). Du point de vue de l’information, chaque bit sous forme de 0 ou de 1 correspond à quatre aires de Planck, ce qui permet de retrouver la formule de Bekenstein-Hawking S = A/4 pour l’entropie. Tout se passe comme si l’information perdue pour un observateur extérieur – l’entropie du trou noir – portée initialement par la structure 3D des objets ayant traversé l’horizon des événements, était codée sur sa surface 2D à la façon d’un hologramme, et t’Hooft en conclut que l’information avalée par un trou noir devait être intégralement restituée lors du processus d’évaporation quantique.

Continuer la lecture de L’univers holographique (3) : De l’entropie à l’hypothèse holographique