Deux prénoms qui sonnent comme deux légendes, deux personnages aux destins fort différents mais que rapproche un génie leur ayant permis de poser des jalons décisifs et ainsi permettre une prodigieuse avancée de la connaissance.

Evariste et Werner, plutôt, pour respecter la chronologie.

Le premier, mort dans des conditions qui demeurent en partie mystérieuses, foudroyé en pleine jeunesse lors d’un combat imbécile et ayant tout juste eu le temps, la veille, de rédiger à nouveau un mémoire fondamental malencontreusement égaré quand il ne fut pas tout simplement jugé indigne d’intérêt. A moins que sa lumineuse intelligence n’ait été considérée comme un risque pour l’aura de certains.

Le second, décédé juste avant d’avoir atteint les trois-quarts de siècle, a écrit 24 ans un article contenant presque tout de la théorie qui aujourd’hui explique le monde, des quarks aux étoiles à neutrons, pour reprendre les mots de Tomonaga. De ce travail d’une audace intellectuelle sans précédent, l’un des plus grands physiciens du 20ème siècle, Max Born, rationaliste parmi les rationalistes, a dit qu’il était “mystique mais sûrement exact”…

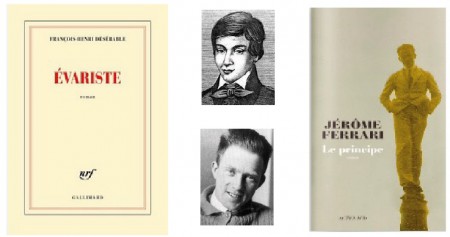

Si Jérôme Ferrari est un écrivain reconnu et distingué — il reçut le Goncourt en 2012— que sa fascination pour Werner Heisenberg a conduit à écrire Le Principe (Actes Sud, 2015), François-Henri Désérable a dû délaisser un temps sa crosse de hockeyeur professionnel pour reprendre une plume lui ayant déjà valu des distinctions et faire réellement son entrée dans le monde des livres avec Evariste (Gallimard, 2015), que l’on peut prendre pour un vibrant hommage à Evariste Galois, génial mathématicien fauché dans la fleur de l’âge.

Dans leurs récits aux allures de biographie, ces deux auteurs ont néanmoins en commun la volonté de percer les zones d’ombre qui, sans doute, ne cesseront de planer sur les deux destins exceptionnels qu’ils nous invitent à découvrir.

Deux récits et deux styles fort différents : si Ferrari donne parfois dans un lyrisme quelque peu excessif — mais nul doute que le dramatique contexte historique l’autorise —, Désérable n’hésite pas à ne jamais abandonner le terrain de l’humour et de la drôlerie : que l’on se rende par exemple à page 22 afin de sourire devant la description imaginaire de l’effusion entre Adélaïde et Gabriel qui, on en jurerait, n’avaient pas l’esprit encombré par la question de savoir si oui ou non le fruit de leur étreinte allait quelque vingt ans plus tard écrire un traité sur la résolubilité des équations par radicaux…

Au-delà de leurs mérites propres et complémentaires, ces deux ouvrages sont comme deux portes ouvertes ne demandant qu’à être franchies pour en savoir beaucoup plus sur les multiples facettes de deux génies engagés dans leur siècle. Le lecteur trouvera sans peine de nombreux livres et documents pour satisfaire sa curiosité mais je crois cependant utile d’en citer deux : L’opération Epsilon, les transcriptions de Farm Hall (Flammarion, 1993), qui retranscrit les bandes magnétiques enregistrées à Farm Hall, et les œuvres complètes d’Evariste Galois, numérisées et disponibles à l’adresse https://ia802707.us.archive.org/31/items/uvresmathmatiqu00frangoog/uvresmathmatiqu00frangoog.pdf